Alibaba Cloud의 비디오 생성 모델인 Wan 2.1(Wan)이 Apache 2.0 라이선스 하에 오픈소스로 공개되었습니다. 이번 릴리스에는 14B와 1.3B 파라미터 버전의 모든 추론 코드와 가중치가 포함되어 있으며, 텍스트-투-비디오 및 이미지-투-비디오 작업을 모두 지원합니다. 전 세계 개발자들은 GitHub, HuggingFace, Modao 커뮤니티에서 모델에 접근하고 체험할 수 있습니다.

모델의 오픈소스 파라미터 버전:

Wan 2.1 모델의 14B 버전

- 성능: 명령어 수행, 복잡한 모션 생성, 물리적 모델링, 텍스트-투-비디오 생성에서 뛰어난 성능을 보입니다.

- 벤치마크: 권위 있는 VBench 평가 세트에서 총점 86.22%를 달성하여 Sora, Luma, Pika와 같은 다른 모델들을 크게 앞지르며 1위를 차지했습니다.

Wan 2.1 모델의 1.3B 버전

- 성능: 더 큰 오픈소스 모델들을 능가하며 일부 클로즈드소스 모델들과도 맞먹는 성능을 보입니다.

- 하드웨어 요구 사항: 8.2GB의 VRAM만으로도 소비자용 GPU에서 실행 가능하며, 480P 비디오를 생성할 수 있습니다.

- 응용: 2차 모델 개발 및 학술 연구에 적합합니다.

2023년부터 Alibaba Cloud는 대형 모델의 오픈소스화에 힘써왔습니다. Qwen에서 파생된 모델의 수는 10만 개를 넘어섰으며, 이는 전 세계적으로 가장 큰 AI 모델 패밀리입니다. Wan 2.1의 오픈소스화로 Alibaba Cloud는 이제 두 가지 기본 모델을 완전히 오픈소스화하여 멀티모달, 전 규모 대형 모델의 오픈소스화를 달성했습니다.

Wan 2.1(Wan) 모델의 기술 분석

모델 성능

Wan 2.1 모델은 다양한 내부 및 외부 벤치마크 테스트에서 기존의 오픈소스 모델들과 최고의 상용 클로즈드소스 모델들을 능가합니다. 이 모델은 회전, 점프, 회전, 굴러가기와 같은 복잡한 인체 움직임을 안정적으로 보여줄 수 있으며, 충돌, 반동, 절단과 같은 복잡한 실제 물리적 시나리오를 정확하게 재현할 수 있습니다.

명령어 수행 능력 측면에서, 이 모델은 중국어와 영어로 된 긴 텍스트 명령어를 정확하게 이해하고 다양한 장면 전환과 캐릭터 상호작용을 충실히 재현할 수 있습니다.

핵심 기술

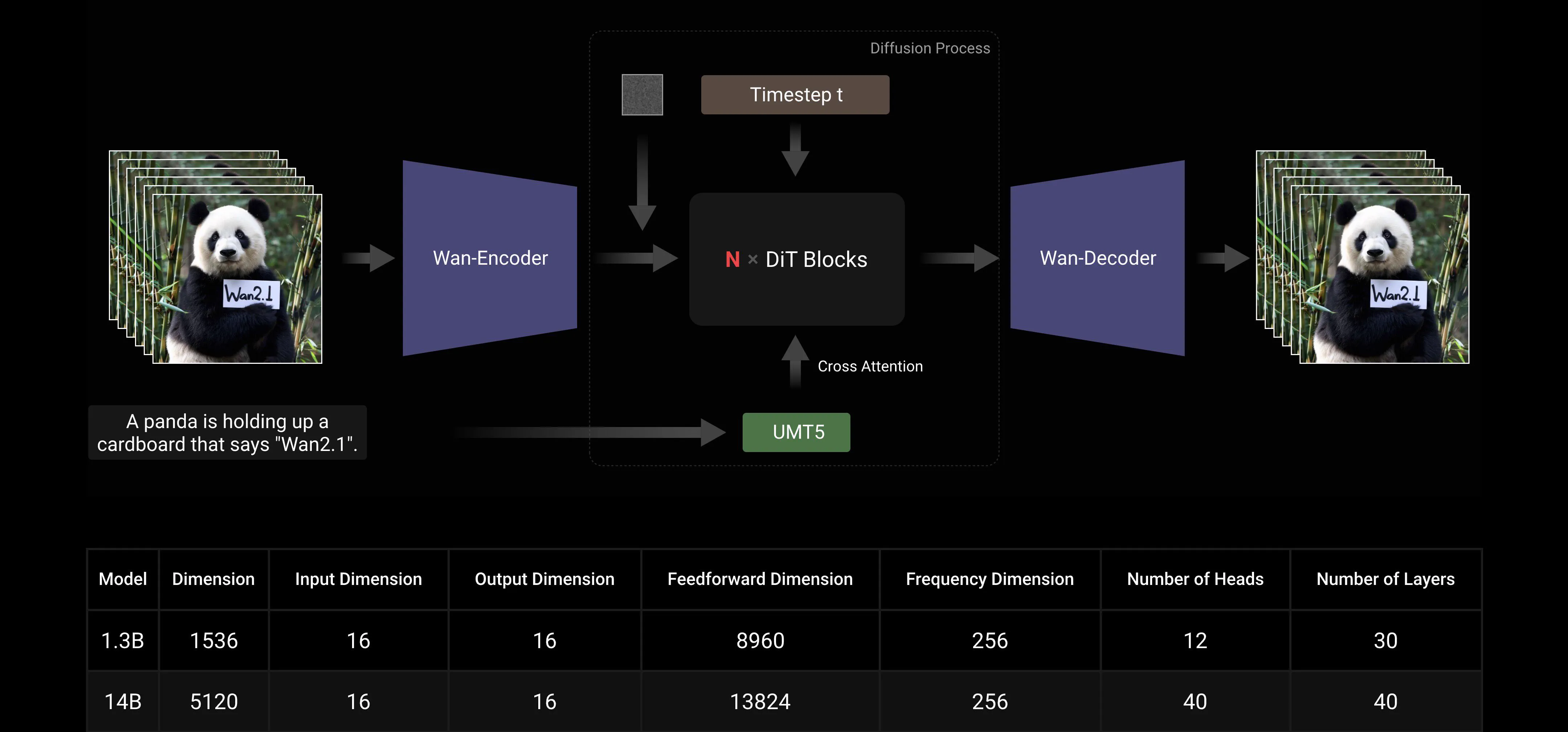

주류 DiT 및 선형 노이즈 스케줄 Flow Matching 패러다임을 기반으로, Wan AI 대형 모델은 일련의 기술 혁신을 통해 생성 능력에서 큰 진전을 이루었습니다. 이러한 혁신에는 효율적인 인과적 3D VAE 개발, 확장 가능한 사전 훈련 전략, 대규모 데이터 파이프라인 구축, 자동화된 평가 지표 구현이 포함됩니다. 이러한 혁신들은 모델의 전반적인 성능을 향상시켰습니다.

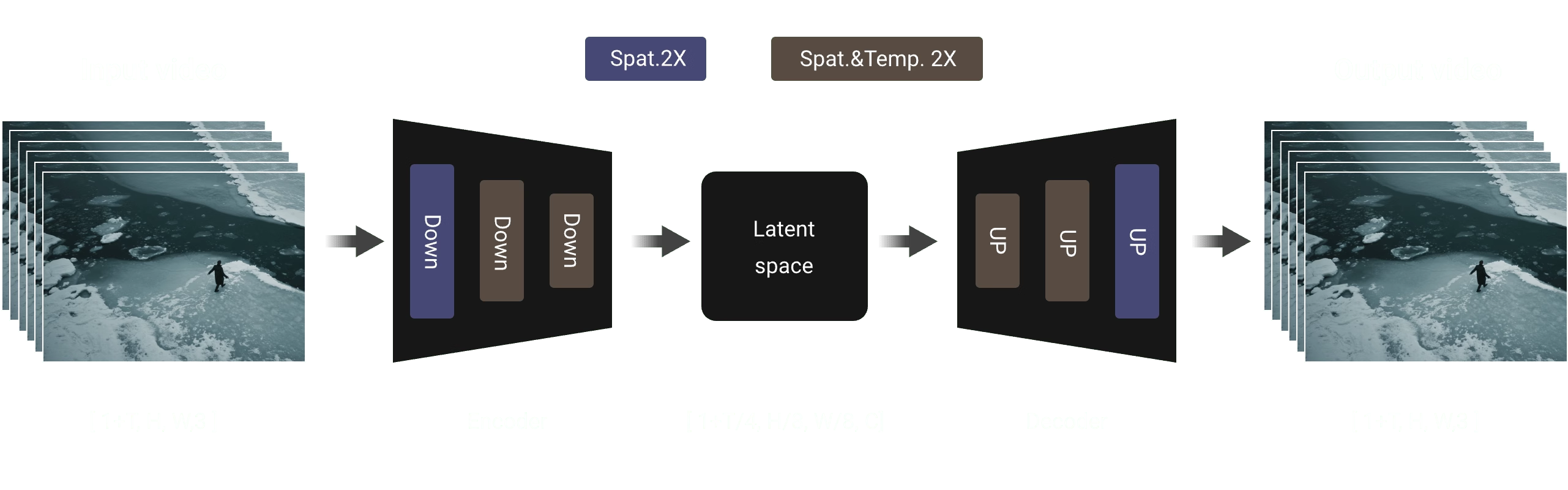

효율적인 인과적 3D VAE: Wan AI는 비디오 생성을 위해 특별히 설계된 새로운 인과적 3D VAE 아키텍처를 개발했으며, 시공간 압축 개선, 메모리 사용량 감소, 시간적 인과성 보장을 위한 다양한 전략을 통합했습니다.

비디오 디퓨전 트랜스포머: Wan AI 모델 아키텍처는 주류 비디오 디퓨전 트랜스포머 구조를 기반으로 합니다. Full Attention 메커니즘을 통해 장기 시공간 의존성을 효과적으로 모델링하여 시간적 및 공간적으로 일관된 비디오 생성을 달성합니다.

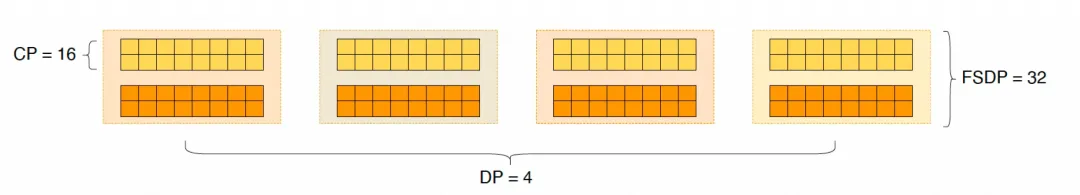

모델 훈련 및 추론 효율 최적화: 훈련 단계에서, 텍스트 및 비디오 인코딩 모듈을 위해 Data Parallelism(DP)과 Fully Sharded Data Parallelism(FSDP)을 결합한 분산 전략을 사용합니다. DiT 모듈을 위해 DP, FSDP, RingAttention, Ulysses를 통합한 하이브리드 병렬 전략을 채택합니다. 추론 단계에서, 다중 GPU를 사용한 단일 비디오 생성의 지연 시간을 줄이기 위해 Collective Parallelism(CP)을 선택해야 합니다. 또한 모델이 클 경우 모델 슬라이싱도 필요합니다.

오픈소스 커뮤니티 친화적

Wan AI는 GitHub와 Hugging Face에서 여러 주류 프레임워크를 완전히 지원합니다. 이미 Gradio 경험과 xDiT를 통한 병렬 가속 추론을 지원하고 있습니다. Diffusers 및 ComfyUI와의 통합도 빠르게 진행 중이며, 이를 통해 개발자들이 원클릭 추론 배포를 할 수 있도록 합니다. 이는 개발 문턱을 낮출 뿐만 아니라, 빠른 프로토타이핑이나 효율적인 프로덕션 배포를 원하는 다양한 사용자들에게 유연한 선택지를 제공합니다.

오픈소스 커뮤니티 링크:

Github: https://github.com/Wan-Video HuggingFace: https://huggingface.co/Wan-AI

부록: Wan AI 모델 데모 쇼케이스

중국어 텍스트 생성을 지원하며 동시에 중국어와 영어로 텍스트 효과 생성을 가능하게 하는 첫 번째 비디오 생성 모델:

더 안정적이고 복잡한 모션 생성 능력:

더 안정적이고 복잡한 모션 생성 능력:

더 유연한 카메라 제어 능력::

더 유연한 카메라 제어 능력::

고급 텍스처, 다양한 스타일, 다중 화면 비율:

고급 텍스처, 다양한 스타일, 다중 화면 비율:

이미지-투-비디오 생성, 창작을 더욱 제어 가능하게:

이미지-투-비디오 생성, 창작을 더욱 제어 가능하게: